Das Mooresche Gesetz der Biologie

Mehr Effizienz in der Genomforschung durch “Compressive Genomics”

DNA Sequenzierer wie der "3730xl DNA Analyzer" werten DNA-Sequenzen im Labor aus und erzeugen dabei große Datenmengen. (Bildquelle: © Jurvetson / Flickr/ CC BY 2.0)

Der technologische Fortschritt bei der DNA-Analyse hat die Wissenschaft revolutioniert. Noch nie war es leichter und günstiger, Sequenzanalysen durchzuführen. Doch damit steht die Wissenschaft vor einem neuen Problem: Speicherung und Verarbeitung der Sequenzierungsdaten hinken hinterher. Einen Lösungsweg sehen Forscher in der „Compressive Genomics“, die geschickte Komprimierung von Rohdaten ohne Informationsverlust. Ein neues Werkzeug aus diesem Bereich heißt CORA.

Irgendwann zwischen 2006 und 2009 muss es so weit gewesen sein, hat der Forscher Scott D. Kahn berechnet. Gemeint ist der Tag, an dem der tägliche Zuwachs an Sequenzierungsdaten (gemessen in Kilobasen pro Tag) erstmals über der durchschnittlichen Zunahme der Rechenleistung und Speicherkapazität lag. Dank neuester DNA-Sequenzierungstechnologien, dem “Next Generation Sequencing”, verdoppeln sich die Sequenzierungskapazitäten in immer kürzeren Abständen, derzeit etwa alle vier Monate, während für Rechenleistung und Speicherkapazität nach wie vor die Faustzahlen von Gordon Moore (Mooresches Gesetz) und Mark Kryder (Krydersches Gesetz) gelten. Sprich eine Verdopplung alle 18 bzw. 13 Monate. Zwei divergierende Trends, die in Kombination eine Herausforderung für die Genomforschung und somit auch für die Pflanzenforschung darstellen.

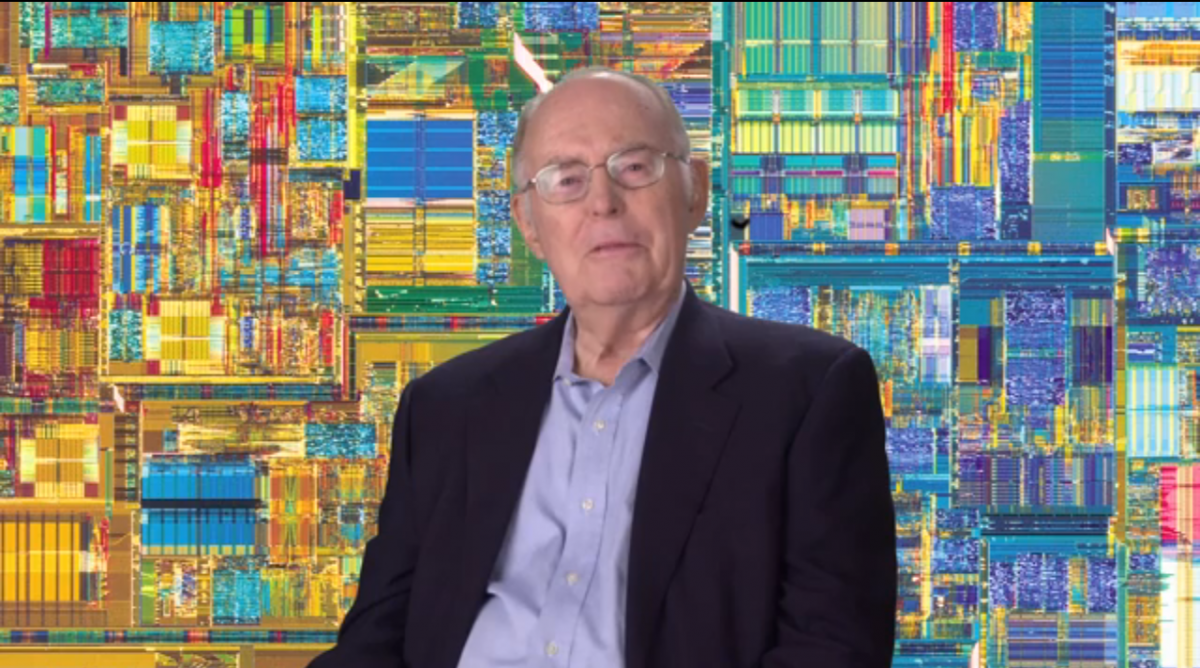

Gordon Moore, Urheber der digitalen "Weltformel", dem Mooreschen Gesetz. Demnach verdoppelt sich die Rechenleistung von Computern alle 18 Monate. Zu langsam für die Wissenschaft?

Bildquelle: © Chemical Heritage Foundation/ wikimedia.org/ CC BY-SA 3.0

Wenn aus der Flut ein Tsunami wird

„Je besser und billiger die Techniken der Genomsequenzierung werden, umso mehr erwarten wir eine Explosion der Erbgutentzifferung, die eine gewaltige Datenflut nach sich zieht“, erklärt Gene Robinson. Ein Forscher, der das Problem aus der Praxis kennt. Mittlerweile nutzen Insider das Bild eines Datentsunamis, der vieles droht wegzuspülen.

Ein Hauptproblem ist die Hardware. Sie zwingt praktizierende Forscher, bei der Analyse und Auswertung von immer mehr und immer größeren Datensätzen umzudenken, neue Wege zu gehen. Unter der Überschrift „Compressive Genomics“ werden seit wenigen Jahren neue Konzepte vereint, vor allem Softwareprogramme und Algorithmen, die darauf abzielen, die zur Verfügung stehenden Ressourcen, insbesondere Rechenleistung und Speicherplatz, effizienter als bisher zu nutzen.

Das Grundprinzip: Schonen statt strapazieren

Neben der Optimierung der technischen Möglichkeiten, geht es vor allem um die Realisierung von Einsparpotenzialen. Beispielhaft verdeutlicht dies eine aktuelle Studie, in der Forscher ein von ihnen entwickeltes Programm präsentieren: CORA, die Abkürzung für “Compressive Read-Mapping Accelerator”. Ein Add-On zur Beschleunigung des Read Mapping, bei der ein bereits vorhandenes Referenzgenom als Interpretationsgrundlage für einen neu sequenzierten Datensatz genutzt wird.

Doch von welchen Einsparmöglichkeiten ist hier die Rede? Projektleiterin Bonnie Berger, bringt es auf den Punkt: „Nehmen wir als Beispiel des menschliche Genom. Im Durchschnitt unterscheidet es sich von Mensch zu Mensch in nur 0,1 %.“ Bei einer durchschnittlichen Größe von etwa 3,27 Milliarden Basenpaaren ein immer noch beachtlicher Wert. Es bedeutet im Umkehrschluss aber, dass sich die menschlichen Genome statistisch in 99,9 % gleichen. Forscher sprechen von Redundanz. Ein Phänomen, das nicht nur auf Menschen zutrifft, sondern grundsätzlich auf alle Organismen einer Art.

Beschränkung auf das Wesentliche

Berger erklärt das Grundprinzip: „Während das individuelle und einzelne Genom tatsächlich nicht komprimierbar ist, verhält es sich bei der Zusammenstellung von vielen ähnlichen Genomen anders. Wir machen uns die Redundanz zunutze und berücksichtigen diese bei der Speicherung, Strukturierung und Formatierung. Durch die Beschränkung auf das Wesentliche werden Ressourcen geschont. Gleichzeitig bleiben die feinen, aber wichtigen Unterschiede wie Nukleotidsubstitutionen, Insertionen, Deletionen oder Gen-Rearrangements erhalten.“

Deniz Yorukoglu, Erstautor der Studie ergänzt: „Obwohl diese prozentual nur einen kleinen Anteil an der Gesamtinformation darstellen, sind es genau diese kleinen Unterschiede zwischen den Genomen, für die wir uns interessieren. Diese zu identifizieren und zu verstehen, ist Aufgabe der Genomforschung.“

Fokus auf das wirklich Neue

Doch wie sieht die Vorgehensweise in der Praxis aus? Wie gelingt CORA und vergleichbaren Konzepten der Spagat, wissenschaftliche Daten von hoher Aussagekraft, Genauigkeit und Nutzen zu generieren und zu verwalten und gleichzeitig digitale Ressourcen zu schonen? Die Antwort: Indem nicht die gesamte Sequenzinformation des untersuchten Organismus gespeichert werde, sondern nur die Abweichungen, das wirklich Neue, heißt es in der Studie.

Der Vollständigkeit halber werden die redundanten Informationen aber nicht gelöscht, sondern zum entsprechenden Abschnitt im Referenzgenom verlinkt. Damit hat der Betrachter stets die vollständige Sequenz vor sich, während im Hintergrund aber Rechen- und Speicherkapazitäten geschont werden. Ein Vorgehen, das nicht ganz neu ist, aber kontinuierlich weiterentwickelt und beschleunigt wird. Kerngedanke ist, keinen Rechenschnitt zweimal zu tätigen, jede Information nur einmal zu speichern. Ein Alleinstellungsmerkmal von CORA ist, dass es im Falle des Auftretens von Sequenzen, die nicht nur einem, sondern mehreren Abschnitten im Referenzgenom zugeordnet werden können (Multi-Mapping-Reads) nicht versagt.

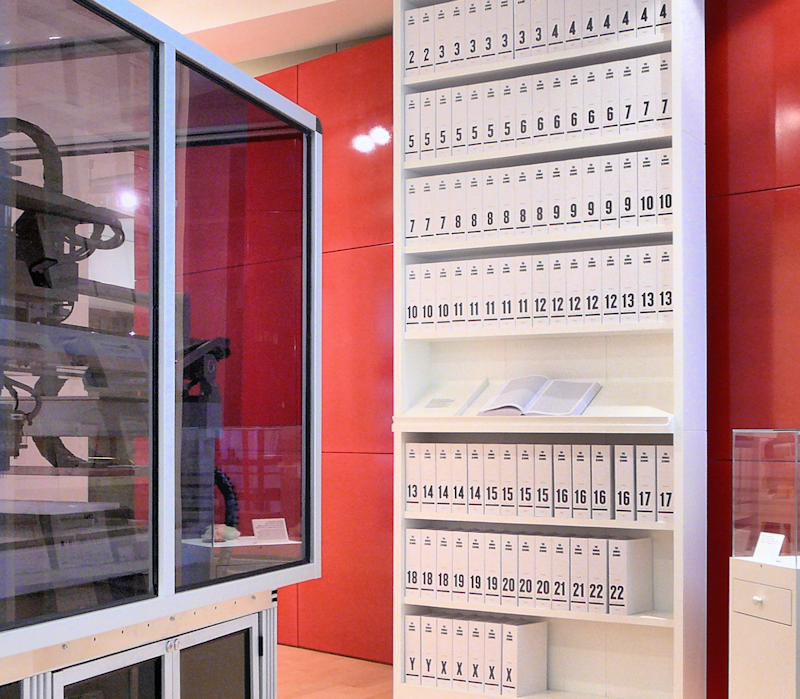

Der erste Ausdruck des menschlichen Genoms in Buchform. Die Information der 3,27 Milliarden Basenpaare der DNA wurde überführt in mehr als 100 Buchbände, jedes mit 1000 Seiten, in kleinstmöglicher Schrift.

Bildquelle: © Russ London/ wikimedia.org/ CC BY-SA 3.0

Smarte Algorithmen trennen die Spreu vom Weizen

Bedeutet die Verfügbarkeit eines Programms wie CORA, dass nun analog zum menschlichen Genom 99,9 % mehr Rechen- Speicherressourcen zur Verfügung stehen und der Datentsunami gestoppt ist? Mitnichten. Schließlich erfordern die Identifikation der redundanten Informationen und die folgenden Schritte eine große Rechenleistung vom Computer. Nicht vergessen werden darf, dass beim Abgleich mit dem Referenzgenom eine gewisse Toleranz eingeplant werden muss, sprich smarte Algorithmen benötigt werden, die wiederum mehr Rechenschritte und Kapazitäten benötigen als ihre Vorgänger.

Denn wer denkt, dass das Read-Mapping der Suchfunktion in einem Textdokument entspricht, bei dem gezielt nach einem bestimmten Wort bzw. einer Sequenz im Referenzgenom gesucht wird, unterschätzt die Komplexität der Genomdaten. Es müssen Punktmutationen, bruchstückhafte oder fehlende Einheiten in den Sequenzen berücksichtigt werden. Hier liegt die Krux: Smarte Algorithmen müssen fähig sein, Sequenzen trotz kleiner Veränderungen und Abweichungen nicht gleich als neu, sondern als redundant zu klassifizieren. Eine knifflige Gratwanderung und ein Albtraum für Informatiker, die für gewöhnlich klare und unmissverständliche Befehle erteilen.

Exabytes an Genomikdaten

Wissenschaftler wie Dr. Gene Robinson halten es für sehr wahrscheinlich, dass in weniger als zehn Jahren nicht mehr Medienplattformen wie YouTube, gemessen am Speichervolumen an der Spitze stehen werden, sondern Gendatenbanken mit Exabytes (Milliarden Gigabytes) von Genomdaten. Neben der Entwicklung von smarten Algorithmen und einer neuen Generation von Hochleistungsrechnern wird es zwingend sein, den weltweiten Umgang mit Forschungsdaten zu überdenken. Gelingt dies nicht, würden wichtige Informationen nicht mehr auszuwerten sein und die Genomforschung Gefahr laufen, unter der Datenlast zu kollabieren.

Quellen:

- Yorukoglu, D. et al. (2016):Compresive mapping for next generation sequencing. In: Nature Biotechnology Vol. 34 (4), (7. April 2016), doi:10.1038/nbt.3511

- Stephens, Z. et al. (2015): Big Data: Astronomical or Genomical? In: PLOS Biology Vol. 13 (7), (7. Juli 2015), doi.org/10.1371/journal.pbio.1002195

- Kahn, S. (2011): On the Future of Genomic Data. In: Science Vol 331 (6018), (11. Februar 2011), DOI: 10.1126/science.1197891

- Berger, B. et al. (2012): Compressive Genomics. In: Nature Biotechnology Vol. 30 (7), (10. Juli 2012), doi:10.1038/nbt.2241

Weiterlesen auf Pflanzenforschung.de:

Titelbild: DNA Sequenzierer wie der "3730xl DNA Analyzer" werten DNA-Sequenzen im Labor aus und erzeugen dabei große Datenmengen. (Bildquelle: © Jurvetson / Flickr/ CC BY 2.0)